Vertrouwen vergroten door middel van Explainable Artificial Intelligence (XAI)

Om een master af te ronden moet je een scriptie schrijven. Niet helemaal mijn ding, heel veel lezen, heel veel schrijven maar gelukkig bestaat er ook de optie om voor een afstudeerstage te kiezen. Nog steeds een scriptie schijven maar dan in samenwerking met een bedrijf over een fenomeen dat niet alleen maar theoretisch van toepassing is. Met mijn interesse in artificial intelligence (AI) en explainable artificial intelligence (XAI) ben ik dus opzoek gegaan naar een bedrijf om een afstudeerstage bij te doen.

Dave Emons

Tot mijn geluk reageerde een oud-student en data scientist van Shintō Labs op mijn oproep op LinkedIn. Hij vertelde me over Shintō Labs die data gedreven oplossingen ontwikkelen voor de overheid. En over een AI toepassing op het gebied van document classificatie waar de eindgebruikers een enigszins sceptische houding tegenover hadden aangenomen. Dat klinkt als de ideale casus: vergroot het vertrouwen door met XAI inzicht te bieden in de redenering van de document classificatie AI. Bij de eerste kennismaking kon ik al proven van de sfeer en mentaliteit van Shintō Labs, veel autonomie, no-nonsense en een drive om door te blijven groeien. Alles leek eigenlijk te mooi om waar te zijn. Gek genoeg was het allemaal gewoon waar.

Vakken volgen aan de universiteit vond ik eigenlijk maar saai. Het verliep allemaal soepel en ik kwam gewoon opdagen maar ik verveelde me vooral. Mijn afstudeeropdracht bood hierin de uitkomst. Hier had ik zelf de touwtjes in handen en kon ik mijn ei helemaal in kwijt. De wekelijkse meetings met data scientist Wesley hielpen mij enorm om niet te hard van stapel te lopen, een planning te maken en bij te sturen waar nodig. Naast een hoop gezelligheid had ik ook genoeg sparring partners en was er ook de ruimte om zelf ideeën aan te dragen. Tot mijn verbazing werd ik zelfs meegenomen in de werking van heel het bedrijf met de maandelijkse Shinteam meetings en voelde ik me echt onderdeel van het team. Zo kon ik ook nog een beetje proeven van wat me te wachten stond na de universiteit wat alleen maar motiveerde. Al met al, voor mij de ideale plek voor een afstudeerstage.

In dit blog vertel ik graag meer over mijn onderzoek, wat ik geleerd heb en wat de resultaten zijn. Of check de video waarin ik erover vertel.

De casus

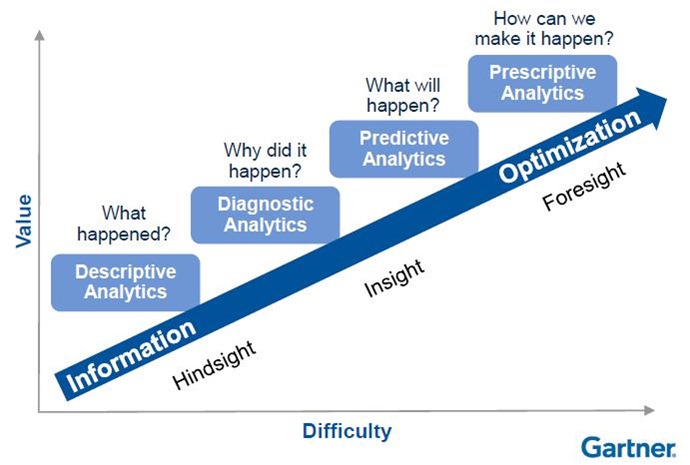

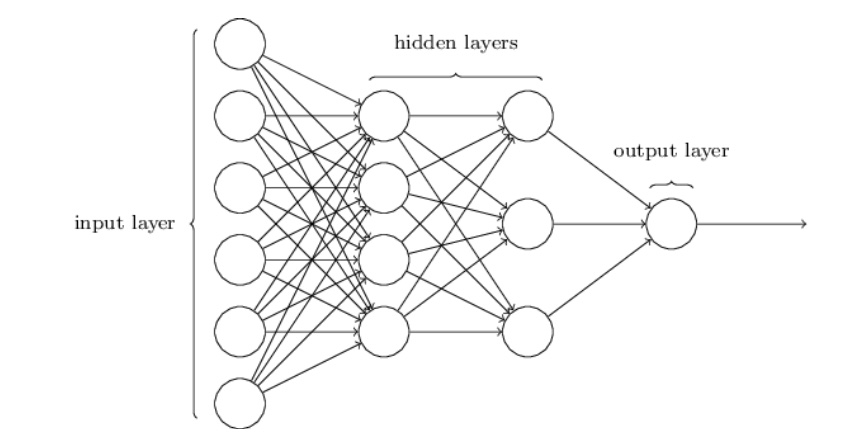

Toen ik net begon werd mij verteld dat de AI een ‘multiclass large-scale natural language processing text classification probleem oplost met een multilayer perceptron gebaseerd op word count’. Een hoop gegoogle en een afstudeer project verder, weet ik inmiddels wel wat dit allemaal betekent maar zal ik pogen het hier simpeler uit te leggen.

Sommige gemeentes krijgen meer dan 10,000 documenten binnen per maand. Deze documenten krijgen allemaal een zaaktype toegewezen zoals “kapvergunning”, “aangifte” of “informatieverzoek”. Voorheen werd dit met de hand gedaan door gemeente medewerkers. De AI ontwikkeld door Shintō Labs scant een document en telt hoe vaak ieder woord voorkomt. Dit wordt vergeleken met voorgaande documenten en zo wordt een van de 243 zaaktypes gesuggereerd. Nu hoeft de gemeentemedewerker enkel nog de AI te controleren aangezien zij verantwoordelijk blijven voor het eindresultaat.

Figuur 1: Illustratie van een MLP architectuur (Rodriquez, 2020)

In deze situatie werken de medewerker en de AI als het ware samen in een team. Hoe goed dit team fungeert hangt voornamelijk af van hoe goed de medewerker is in het accepteren van correcte suggesties van de AI en het corrigeren van foutieve suggesties. De belangrijkste factor in dit team is een gekalibreerd vertrouwen in de AI. Mocht de medewerker te veel vertrouwen hebben in de AI dan worden te veel foutieve suggesties geaccepteerd zonder kritisch na te denken. Mocht er te weinig vertrouwen zijn dan worden te veel correcte suggesties genegeerd.

Vertrouwen in mens-AI teams ontwikkelt zich ongeveer hetzelfde als vertrouwen tussen mensen. Stel je vraagt een collega om eenmalig een taak van je over te nemen maar je collega verprutst dit, dan ben je minder snel geneigd deze collega in de toekomst wederom een taak toe te vertrouwen. Doet je collega het goed, dan bevestigd dat het vertrouwen dat je in hen plaatst en vraag je ze in de toekomst misschien weer. Op een soortgelijke manier als mensen een AI een fout zien maken daalt hun vertrouwen. Pas na lange periodes dat de AI het goed doet bouwt het vertrouwen langzaam op. Het grootste verschil tussen mens-AI vertrouwen en vertrouwen tussen mensen is dat vertrouwen in AI veel harder daalt wanneer er een fout wordt gemaakt.

Om dit fenomeen tegen te gaan suggereert literatuur om uitleg te bieden naast AI suggesties. Inzicht in hoe een AI anders informatie verwerkt dan mensen (woorden tellen i.p.v. zinnen lezen), de interne werking van een AI en de redenering gebruikt door de AI zijn effectief gebleken in het kalibreren van vertrouwen. Nu is een multilayer perceptron een vorm van een neuraal netwerk, een AI model dat ook beschreven wordt als een black-box model. Hoewel het in theorie mogelijk is alle berekeningen die de AI doet met de hand te doen, wordt je daar niet gelukkig van, dankjewel Business Analytics ☹️, bovendien word je er ook niks wijzer van. Deze laatste eigenschap maakt het een black-box model. Explainable artificial intelligence technieken zijn ontworpen om toch inzicht te krijgen in de werking van black-box modellen.

SHAP en Natural Language Processing

Een computer kan niet lezen, in ieder geval niet op de manier hoe wij mensen dit doen. In plaats daarvan telt de AI hoe vaak ieder woord voorkomt in een document in verhouding tot in hoeveel documenten dit woord ten minste een keer voorkomt. Doet noemt men term-frequency inverse-document-frequency (tf-idf) wat een waarde produceert tussen de 0 en 1 voor ieder woord. Een hoge waarde geeft aan dat dit woord vaak voorkomt in dit document en zelden in andere documenten. Dit geeft een indicatie dat dit woord definiërend is voor dat document. Ieder document wordt gecodeerd als tf-idf waardes voor alle woorden in het vocabulaire van de AI (16,618 woorden). Deze waardes worden vervolgens door de multilayer perceptron (het neuraal netwerk) gebruikt om te berekenen welk van de 243 zaaktypes het meest waarschijnlijk is.

Hoewel tf-idf waardes een indicatie geven welke woorden belangrijk zijn voor een bepaald document, geeft het geen inzicht in welke woorden de AI uiteindelijk gebruikt om tot een suggestie te komen. Om daar achter te komen is SHAP (SHapley Additive exPlanations) toegepast. SHAP is gebaseerd op shapley values, een concept uit speltheorie dat gebruikt wordt om een spelers contributie binnen een team tot een bepaald doel te bepalen. In ons geval berekent SHAP de contributie van ieder woord tot de uiteindelijke suggestie.

Figuur 2 is een voorbeeld van wat SHAP doet. In dit geval is de AI 95.4% zeker dat een document “gemeenteplek peuteropvang aanvraag” betreft. Het woord dat hier het meeste aan bijdraagt is “kdv” (kinderdagverblijf) en is verantwoordelijk voor 9% van de 95.4% zekerheid.

Figuur 2: SHAP simuleert de AI besluitvorming en berekent de bijdrage van ieder woord aan de zekerheidspercentage

De intuïtie is dat gemeentemedewerkers bovenstaande informatie zien en denken “dat klinkt logisch, dit kan ik vertrouwen”. Maar ook wanneer de AI een fout maakt is het op deze manier mogelijk om te zien welke woorden de AI op een dwaalspoor zette. Hier inzicht in krijgen schept hopelijk meer begrip naar de AI en zorgt er voor dat vertrouwen minder hard daalt wanneer het een fout maakt.

De resultaten

Eindgebruikers hebben deelgenomen aan een experiment waarin ze suggesties van de AI te zien krijgen met of zonder SHAP uitleg. Bij iedere suggestie hebben zij de keuze om de suggestie te accepteren of af te wijzen. De helft van de suggesties zijn correct zodat iemand die simpelweg zou gokken 50% correct zou accepteren en afwijzen. Deelnemers met uitleg behalen een score van 52.7% tegenover een score van 45% zonder uitleg. Dit klinkt veelbelovend maar wegens het kleine aantal deelnemers (n=8) is er geen statistisch significant verschil (eenzijdige proportie test, P<0.3).

Wegens het kleine aantal deelnemers en een grote variatie in ervaring met de AI is het niet mogelijk conclusies te trekken of uitleg ervoor zorgt dat deelnemers vaker de AI vertrouwen of dat het vertrouwen minder daalt wanneer de AI een fout maakt. Het valt wel op dat deelnemers met meer ervaring met de AI het veel minder vertrouwen. Zij accepteren 36.7% van de suggesties tegenover 77.8% van deelnemers met weinig tot geen ervaring met de AI (eenzijdige proportie test, P<0.0005). Deze bevinding is in lijn met bestaande literatuur en de gerapporteerde sceptische houding van de medewerkers.

Het lijkt er dus op dat naarmate mensen meer ervaring hebben in samenwerken met AI ze de AI meer fouten zien maken en steeds minder gaan vertrouwen. Uitleg toevoegen aan AI suggesties lijkt een mogelijke oplossing te zijn maar er is meer data nodig om hier betrouwbare conclusies over te trekken.

De noodzaak om iets te doen aan het dalende vertrouwen binnen mens-AI teams is duidelijk. Zelf denk ik nog steeds dat XAI hier een veelbelovende rol in kan spelen. Het helpt mij als ingenieur in ieder geval om duidelijk te krijgen dat de AI het probleem oplost dat ik wil dat het oplost. Ik verwacht veel van wat ik tijdens dit project geleerd te heb toe te kunnen passen nu ik een carrière in de industrie begin. Verder hoop ik vooral dat Shintō Labs hier ook iets aan hebben en doorgaan met betekenisvolle datagedreven oplossingen maken.

Foto credits: Shahadat Rahman on Unsplash